36 : Où en est la mécanique numérique ?

Incontournable, la mécanique numérique s’insère aujourd’hui dans l’ensemble de la chaîne de conception rapide des produits fabriqués par l’industrie. S’appuyant sur les outils de modélisation géométrique et de visualisation, et intégrant les outils de simulation et d’optimisation, elle réduit les délais de conception, limite les erreurs et s’insère dans l’esprit du développement durable en aidant à concevoir des produits de plus en plus respectueux de l’environnement.

Pour l’UTC, ce domaine n’est pas uniquement un des nombreux domaines dans laquelle elle s’investit en tant que structure dédiée à l’enseignement des sciences et technologies. Lancée dans les années 1970 par trois pionniers, Jean Louis Batoz, Gouri Dhatt et Gilbert Touzot, la mécanique numérique a constitué un domaine d’excellence à l’UTC avec plus de 200 thèses présentées, confirmant une place de leader dans le domaine.

Si aujourd’hui la discipline s’est largement répandue, l’UTC a néanmoins souhaité célébrer ses 40 ans d’investissement en organisant un colloque les 26 et 27 novembre 2015. L’objectif est à la fois de rappeler le temps des pionniers, mais aussi de faire le point sur les avancées et la manière dont les outils de simulation se sont développés, touchant des domaines de plus en plus nombreux. Banalisés dans l’industrie mécanique, ces outils concernent aujourd’hui de nombreux secteurs d’activités où des comportements multiphysiques sont susceptibles d’être simulés.

” Il existe encore d’importantes marges de progrès, comme en biomécanique et sciences de l’environnement, par exemple ” explique Jean Louis Batoz, professeur Emérite à l’UTC qui souligne aussi des perspectives dans le domaine de la physique appliquée à des environnements complexes, multiphysiques et multiéchelles comme la physique urbaine. Autre particularité du colloque de novembre, la remise du diplôme de Docteur Honoris Causa à Klaus-Jürgen Bathe, un des plus éminents pionniers du domaine.

D’origine allemande, Klaus-Jürgen Bathe travaille depuis 40 ans au MIT où il s’est confronté aux aspects les plus fondamentaux du domaine, ainsi qu’à la réalisation de logiciels d’utilisation industrielle. Auteurs de plusieurs livres et de centaines d’articles, il est impliqué dans une vingtaine de revues internationales.

Depuis la simulation de la réaction nucléaire à Los Alamos ou l’invention de la mécanique des fluides numérique par la NASA dans les années 1940, à la systématisation de l’usage des outils numériques dans la conception industrielle actuelle, la mécanique numérique est passée par toutes sortes d’étapes. Avec comme objectif constant d’améliorer les simulateurs afin de gagner du temps et de la précision.

Manque de temps, difficultés à mener des expériences grandeur nature et apparition des premiers calculateurs numériques, la fin de la seconde guerre mondiale et plus particulièrement le projet Manhattan constituent le berceau de la simulation numérique. Les premiers travaux ont consisté à simuler les modèles de propagation de réactions nucléaires, utilisés pour fabriquer les premières bombes atomiques.

Alors que les calculateurs de l’époque mettaient plusieurs secondes pour réaliser une multiplication, un changement s’opère dans les années 1970 où la puissance de calcul augmente significativement. Les outils de simulation mécanique commencent à trouver leur place dans l’industrie. ” Au Centre Technique des Industries Mécaniques (CETIM) ou à l’UTC, les premières recherches débutent dans les années 1972–75 et donneront naissances aux premiers logiciels utilisés par l’industrie dans les années 1980 ” explique Mansour Afzali, Délégué scientifique au CETIM.

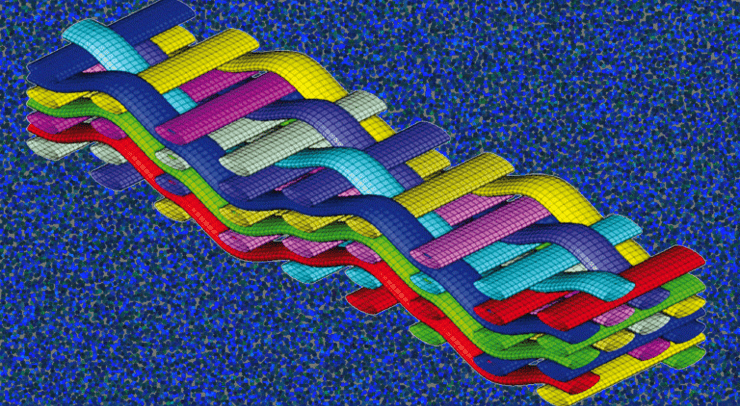

Décomposer l’espace de travail

Une des méthodes les plus utilisée est celle des éléments finis. Elle consiste à décomposer l’espace et les objets en mailles (ou éléments) les plus simples possibles. Le système d’équations complexes qui modélise l’ensemble du système est obtenu par assemblage d’informations calculées sur chaque maille. ” Les premiers temps de la mécanique numérique ont consisté à construire des modèles capables de représenter les objets mécaniques et à les rendre cohérents avec la réalité et les lois de la mécanique ” précise Mansour Afzali.

L’objectif est de simuler le fastidieux processus de la conception manuelle. Elle débute par la réalisation d’un dessin, sur lequel est réalisé un ensemble de calculs afin de le rendre cohérent avec les lois de la physique. Un prototype est alors produit, puis soumis à un ensemble de tests. Selon les résultats, le processus repart, éventuellement au point de départ, afin de corriger les défauts. ” Ce procédé est susceptible d’être réitéré autant de fois que nécessaire, jusqu’à obtenir un prototype passant les tests répondant au cahier des charges ” souligne le délégué scientifique qui précise que les outils de simulation numérique permettent de nombreux tests sur ordinateur évitant de longue et coûteuses itérations.

Si la mécanique numérique a divisé par deux le temps de conception d’une voiture, elle a aussi permis de concevoir un avion comme l’Airbus A380 uniquement à partir de simulation sur ordinateur.

Améliorer les modèles et les logiciels

Une fois les premiers outils de mécanique numérique disponibles dans les années 1980, de nombreux essais sont menés afin de préciser les caractéristiques des matériaux et valider les résultats des calculs. Ces travaux permettent d’améliorer les modèles, ainsi que les logiciels. Ces derniers subissent d’important tests dans les années 1990 afin d’accroître leur fiabilité. De plus en plus d’ingénieurs sont formés à ces outils qui se répandent dans l’industrie.

L’informatique se développe aussi très rapidement et la simulation numérique commence à être intégrée dans la chaine de la conception-fabrication (CFAO). ” Ces différentes avancées, l’accroissement de la robustesse des modèles et l’homogénéisation des démarches de modélisation permettent des gains de temps importants en limitant significativement le nombre d’essais nécessaires ” précise Mansour Afzali. Les outils de mécanique numérique gagnent la confiance des industriels et deviennent incontournables.

De plus en plus de possibilités

La puissance des ordinateurs augmentant régulièrement, il devient possible d’entreprendre d’importants calculs afin d’optimiser les produits. A partir d’un ensemble de paramètres, de contraintes et d’objectifs, l’optimisation consiste à trouver la meilleure solution parmi de nombreuses possibilités.

” L’optimisation est souvent le travail d’ingénieurs compétents car il est nécessaire de faire les bons choix aux différentes étapes de la conception ” explique Mansour Afzali pour qui l’intervention d’un expert reste indispensable afin de vérifier les données fournies et les résultats obtenus. Alors que la puissance des outils explose et que les modèles s’homogénéisent de plus en plus, les études mécaniques intègrent des approches probabilistes afin d’évaluer la durée de vie des composants en tenant compte de la variabilité des paramètres de conception et d’usage. Elles s’intéressent également à des matériaux de plus en plus complexes, comme les matériaux composites. De nouvelles méthodes apparaissent, par exemple pour prendre en compte la vitesse de déformation des matériaux afin de simuler la résistance des structures aux chocs. Aujourd’hui, ces outils concernent aussi bien la conception de boites de conserves que la réponse de la tour Eiffel à des événements climatiques ou sismiques. ”

Tous les composants mécaniques sont modélisés et calculés et l’industrie dans son ensemble a recours à la mécanique numérique ” souligne Mansour Afzali. L’outil est banalisé au point que les jeunes ingénieurs lui font parfois aveuglément confiance, estimant ses résultats au même niveau de fiabilité qu’un essai grandeur nature. Et Mansour Afzali d’insister sur le rôle de l’ingénieur qui ” a la responsabilité de vérifier les hypothèses et les modèles sans jamais oublier que la qualité des résultats de calcul en dépendent “.

Chez le constructeur automobile Renault, l’emboutissage de pièces suit une chaîne de conception numérique depuis le design jusqu’aux tests finaux. Si certaines étapes se standardisent, devenant gérables par des opérateurs de moins en moins qualifiés, la mise en œuvre d’opérations plus élaborées demande la connaissance et le savoir faire d’ingénieurs spécialisés.

” Simuler, c’est faire croire que c’est réel et donc essayer de reproduire ce qui se passe dans la réalité ” précise Frédéric Mercier, Ingénieur de recherche chez Renault, spécialisé en simulation numérique et rattaché au département emboutissage. L’emboutissage consiste à déformer la surface plane d’une tôle pour obtenir une structure en trois dimensions la plupart du temps non assimilable à un plan. Si l’exercice de mise en géométrie n’est pas toujours évident, la pièce doit aussi répondre à un ensemble de caractéristiques d’usages, comme celles exigées pour passer les crash-tests.

” Un bon modèle permet de s’approcher d’une réalité ” explique Frédéric Mercier. La chaîne de conception d’une pièce de carrosserie intègre le design de la pièce, l’ensemble des calculs pour son emboutissage, ainsi que la simulation de la tenue aux chocs. Le nombre d’essais grandeur nature en est significativement limité, la plupart des tests étant réalisés en simulation.

Des opérations courantes facilitées

Concrètement, l’ingénieur modélise la carrosserie par un maillage constitué d’éléments finis dits ” de coque mince “, c’est-à-dire adaptés à des structures minces. Ce type de structures permet de modéliser environ 80% des produits courants et les techniques et outils sont suffisamment simplifiés et standardisés pour qu’ils soient utilisables par des techniciens après une courte formation spécialisée. ” L’utilisation de ces outils se démocratise et les personnels diplômés comme les docteurs ou les ingénieurs sont maintenant sollicités pour des tâches plus complexes ” précise Frédéric Mercier.

L’optimisation une affaire d’experts

C’est le cas de l’optimisation, une tâche qui consiste à trouver les meilleures configurations pour répondrent à une liste de contraintes données. Par exemple, en terme de réduction des émissions de CO2, une piste d’amélioration consiste à alléger la masse du véhicule tout en respectant les contraintes liées aux crashs et à l’acoustique. Comme ces deux critères s’avèrent relativement antagonistes en termes d’épaisseur et de rigidité des tôles, l’optimisation consiste à trouver différentes possibilités répondant aux besoins.

D’autres critères d’arbitrages interviennent alors pour choisir entre ces possibilités, comme le coût ou la facilité de production de la pièce. Les calculs d’optimisation sont généralement plus complexes à mener lorsque des contraintes de chocs sont introduites. Il est alors nécessaire de trouver les bons modèles et les bons outils afin d’éviter des temps de calcul trop longs. ” Il n’est effectivement pas raisonnable de lancer un calcul de plus de 50 heures “, précise Frédéric Mercier.

S’adapter aux cas particuliers

Si l’optimisation est une affaire demandant du doigté, c’est aussi parce que les normes se multiplient. Différentes selon les pays, elles concernent essentiellement la sécurité, les performances et l’environnement. ” En matière de chocs, plus d’une dizaine de situations sont prises en compte ” explique Frédéric Mercier, citant les chocs piétons, frontaux ou latéraux.

Les besoins d’expertise ne se limitent pas à l’optimisation mais concernent aussi des procédés comme l’identification de critères numériques afin de détecter d’éventuels défauts d’aspect ou encore l’utilisation de matériaux composites. Ces derniers se désagrègent en cas de choc, transformant les caractéristiques d’origine du matériau. ” Les logiciels que nous utilisons ne sont pas adaptés à ce type de comportement, même s’il est possible de trouver des façons de les prendre en compte ” souligne Frédéric Mercier.

En matière d’amélioration Frédéric Mercier a aussi quelques idées. Il exprime entre autre le souhait que les concepteurs de logiciels conçoivent des interfaces plus conviviales et modernes. ” Par exemple, elles pourraient s’inspirer des interfaces tactiles développées par Apple ou proposer des outils haptiques ” suggère-t-il, n’hésitant pas à rêver ” de simulateurs numériques pour smartphones et tablettes”. Plus sérieusement, une autre piste d’amélioration concerne le développement des modèles afin de respecter le plus précisément possible les lois physiques. Et même si la puissance des ordinateurs s’est largement décuplée, la réduction des temps de calcul reste toujours d’actualité.

La simulation mécanique, à la base de la conception de nouveaux produits, de prévisions ou d’outil d’apprentissage, est aujourd’hui largement utilisée par l’industrie. Néanmoins, pour tous ces usages, les enjeux qu’ils recouvrent et les résultats attendus n’impliquent forcément les mêmes outils de simulation, ni les mêmes compétences pour ceux qui les mettent en œuvre.

Depuis le stylo à bille posé sur votre tablette à l’airbus A380 dernier cri dans lequel vous voyagez, la conception industrielle débute immanquablement par une étape de simulation du futur produit sur un ordinateur. L’industrie y trouve non seulement un moyen d’élaborer de nouveaux artefacts plus rapidement et à moindres coûts en limitant le recours à des prototypes pour réaliser des tests, mais aussi de concevoir des produits susceptibles de répondre au mieux à un cahier des charges de plus en plus contraint.

L’objet est dessiné, ses propriétés mécaniques modélisées, ainsi que l’environnement et les contraintes de son utilisation. A partir de là ” il est possible de tester de très nombreuses possibilités afin d’optimiser l’objet en fonction de son cahier des charges et de l’utilisation attendue ” explique Francisco Chinesta, professeur à l’Ecole Centrale de Nantes spécialisé dans la mécanique numérique.

Des attentes différentes selon l’objectif

Pour l’ingénieur, toute la difficulté consiste à trouver le niveau de modélisation adéquat afin d’aboutir dans un temps satisfaisant. ” Il est nécessaire d’adapter le modèle à l’objectif ” souligne Francisco Chinesta qui précise que les contraintes en terme de fiabilité, de normes ou de risques ne sont pas les mêmes pour un stylo que pour un avion. Les difficultés pour réaliser la modélisation, concevoir le processus d’optimisation et les temps de calcul dépendent des choix réalisés au départ. Aujourd’hui, certains modèles sont si complexes que mêmes des ordinateurs puissants mettent des mois à obtenir un résultat.

” Quoi qu’il arrive, ce travail d’optimisation ne peut pas aboutir à un résultat éliminant tous les risques ” précise Francisco Chinesta, pour qui le travail réalisé doit être proportionné à la complexité du système à modéliser, aux enjeux et aux attentes. Par exemple, ” une erreur dans une prévision météorologique à quelques jours reste acceptable car chacun sait le système très imprévisible ” explique le chercheur qui précise que les enjeux et les attentes sont différentes lorsqu’il est question de concevoir un avion ou d’élaborer un simulateur pour l’entraînement des chirurgiens.

Dans ce dernier cas, il n’est plus question de modéliser la réalité mais de fournir au chirurgien une sensation la plus proche possible de la réalité. Les perceptions tolérant une marge d’imprécision relativement importante, il n’est alors pas nécessaire de recourir à une modélisation extrêmement précise.

Des outils plus accessibles

Alors que les contraintes sont de plus en plus fortes en matière de sécurité, impliquant des modélisations de plus en plus précises, la tendance est à la démocratisation de ces équipements. L’utilisation de modèles éprouvés et de techniques d’optimisation standardisées permet à des utilisateurs de moins en mois compétents de travailler avec ces outils.

” Aujourd’hui, certaines simulations sont directement réalisées par des techniciens spécialisés sans faire appel à des ingénieurs ” explique Frédéric Mercier, ingénieur de recherche chez Renault, spécialisé en simulation numérique. Si les problèmes les plus compliqués nécessitent encore des personnels très qualifiées et de puissants outils de calcul, Francisco Chinesta imagine néanmoins que de petites applications devraient apparaître, relativement faciles à utiliser et éventuellement disponibles sur tablettes ou même smart-phones. L’objectif consiste véritablement à banaliser ces procédés de simulation pour les mettre en œuvre de plus en plus rapidement et avec de moins en moins de moyens.

Pour les ingénieurs, il s’agit d’apprendre très tôt à travailler sur des problèmes concrets posés par le monde industriel. Les exigences de qualité, de risques, ainsi que les normes les obligent à préciser les demandes et les enjeux et à prévoir un procédé de simulation adapté. Il est alors de la responsabilité des enseignants-chercheurs d’assurer ce contact étroit avec les réalités du métier d’ingénieur et d’adapter l’enseignement aux problématiques réelles.

Selon Francisco Chinesta ” l’UTC a su orienter son enseignement dans ce sens, en s’appuyant sur les véritables questions posées par l’industrie “. Peut-être cette prise en compte de la réalité industrielle a‑t-elle constitué un moteur pour faire de l’UTC un des pionniers et leader français dans le domaine de la simulation mécanique ?

Puissance de calcul des ordinateurs et outils de simulation de plus en plus fiables ont permis le développement de logiciels d’optimisation. Le monde de l’entreprise fourmille de demandes plus ou moins spécialisées afin de réduire les délais de production, minimiser les coûts et améliorer la qualité des produits.

Silencieux, confortable, léger, propre, économe, rapide, précis, sans danger, esthétique… la liste de qualités attendues par un nouveau produit industriel est aujourd’hui infiniment plus longue qu’elle ne l’était jadis. Et concilier ces dernières afin de répondre aux normes et aux attentes des consommateurs peut devenir un vrai casse-tête pour les concepteurs.

Un seul mot pour accomplir cette tache, optimiser ! Pour l’ingénieur concevant une voiture, il s’agit de maximiser sa sécurité, de minimiser ses coûts (de production, de conception, d’utilisation…), de maximiser son confort tout en réduisant sa consommation et… les données du problème apparaissent comme une liste plus ou moins longue de contraintes et d’objectifs à satisfaire. ”

La principale difficulté consiste à formuler précisément le problème d’optimisation “, explique Hossein Shakourzadeh, Conseiller scientifique chez Altair, société spécialisée dans le développement de logiciels de simulation.

Des logiciels pour la route ou le ciel

Par exemple, comment définir ce confort à maximiser? Que faut-il prendre en compte dans le coût ? Autant de questions pour lesquelles il n’existe pas de réponses simples. Et des réponses dépendent finalement les solutions qui seront retenues pour le nouveau produit. Afin d’aider les ingénieurs, les éditeurs de logiciels proposent aujourd’hui une gamme assez importante d’outils d’optimisation.

” Il est nécessaire de trouver des solutions qui répondent à l’ensemble des clients, qu’ils construisent des avions ou des automobiles ” souligne Hossein Shakourzadeh. Bien souvent, des problèmes pourtant différents se résolvent avec les mêmes outils. Des logiciels susceptibles de répondre au plus grand nombre ont donc été développés, paramétrables afin de répondre à un maximum de situations.

Et des modules de plus en plus spécialisés

En plus de ces outils génériques paramétrables, aujourd’hui réservés à des ingénieurs méthodes ou des ingénieurs de recherche, de plus en plus de modules spécialisés sont développés pour réaliser des optimisations dans des situations très spécifiques. Par exemple, le module Squeak and Rattle Director d’Altair a pour fonction de minimiser les frottements et grincements de pièces d’équipements susceptibles de s’altérer avec le temps. L’exemple type reste le tableau de bord des voitures, mais l’outil ne se limite pas à ce cadre. ”

Ces logiciels répondent à une demande des industriels pour gagner du temps lors de la conception et de transférer certaines compétences à l’éditeur de logiciel ” souligne Hossein Shakourzadeh. L’ingénieur en charge de concevoir un tableau de bord ne doit pas aussi être spécialiste des techniques d’optimisations et peut ainsi se concentrer sur son travail. Si ces outils d’optimisation commencent à être utilisés par les industriels dans les années 1990, ils reposent avant tout sur l’amélioration des modèles et des outils de simulation sur lesquels ils s’appuient. L’engouement répond pour une part à la volonté des industriels de réduire les délais de conception, la course économique les poussant constamment à renouveler leurs offres avec de nouveaux produits.

Un autre facteur important est l’augmentation considérable des normes et contraintes que les produits industriels doivent satisfaire. Le monde de l’optimisation ne concerne pas uniquement l’industrie mécanique mais touche aujourd’hui presque tous les domaines. Par exemple, ” les outils d’optimisation des coûts visant à minimiser les coûts et maximiser la qualité sont très utilisés ” souligne Hossein Shakourzadeh. Altair propose même un logiciel afin d’aider les entreprises à optimiser leurs investissements en équipements logiciels. A quand des outils d’optimisation pour optimiser l’utilisation des outils d’optimisation ?

Les outils de simulation numérique ne concernent pas que la conception d’artefacts industriels. L’équipe du laboratoire d’hydraulique numérique hébergée à l’UTC les applique à des situations d’inondation ou de submersion par les eaux, ainsi qu’à d’autres sujets en relation avec les milieux aquatiques et la navigation.

Inondations ou submersions marines, les pouvoirs publiques ont aussi recours aux outils de simulations numériques afin d’aider à l’élaboration de politiques publiques. Créé en 2003 et hébergé au laboratoire Roberval de l’UTC, le laboratoire d’hydraulique numérique (LHN) accueille trois chercheurs du Ministère de l’écologie spécialisés sur ces questions.

Ce groupe travaille ensemble depuis 1991 et se focalise sur la gestion des risques liés à l’eau en lien notamment avec les besoins de la Direction Générale de la Prévision des Risques. Il s’intéresse aussi au transport fluvial et maritime, à la récupération d’énergie à partir des courants et des vagues et aux conséquences du changement climatique en terme de remontée du niveau marin.

Des outils spécifiques

Alors que depuis la fin des années 1970 des outils numériques propres aux problématiques de l’eau sont développés à la Direction Technique Eau Mer et Fleuves du Cerema, Philippe Sergent, son actuel Directeur Scientifique, réalise ce travail depuis la fin des années 1990 avec ses partenaires du LHN. La chaîne de calcul REFLUX élaborée dans les années 1980 intègre un premier étage d’organisation des données, un module de calcul, ainsi qu’un outil de visualisation des résultats. ” REFLUX a été utilisée jusqu’en 2000, puis remplacée progressivement par la chaîne de calcul d’EDF, Telemac ” précise Philippe Sergent.

Particularité du domaine, les données géographiques sont très volumineuses et demandent de développer des outils capables de les stocker et de les traiter. La visualisation des résultats est aussi une difficulté, ces derniers portant sur des milliers de km2. ” Les calculs sont très longs si on compare à ce qui est habituellement réalisé dans l’industrie mécanique ” souligne Philippe Sergent.

Une autre spécificité du domaine concerne l’importante quantité d’inconnues comparée aux simulations classiquement réalisées par l’industrie. Par exemple, il est impossible de prendre en compte l’effet de la saison sur la végétation lorsqu’un territoire est modélisé pour étudier un risque d’inondation. La présence de haies dans les zones résidentielles et la capacité d’infiltration des sols sont aussi difficiles à gérer.

Optimiser le déplacement des navires

Une autre nouveauté consiste à travailler avec des structures en trois dimensions pour modéliser le déplacement des navires. Les simulations servent à mieux comprendre les résistances à l’avancement en milieu confiné afin d’optimiser la consommation des navires. Plus le fond est haut ou le cours d’eau étroit, plus la résistance et la consommation est importante.

En faisant varier la vitesse du navire en fonction de ces paramètres, des gains de 5 à 10% sont attendus. Ces derniers sont susceptibles d’être encore améliorés en optimisant la gestion des écluses. ” Pour ces simulations hydrodynamiques, les calculs peuvent prendre jusqu’à un mois ” précise Philippe Sergent.

Les approches pluridisciplinaires

D’autres développements spécifiques concernent les analyses coûts/bénéfices afin d’optimiser les démarches à entreprendre en cas de risques d’inondation ou de submersion. Ces études demandent des compétences pluridisciplinaires afin de prendre en compte les dimensions économiques, environnementales et sociétales. Les grands enjeux actuels concernent les nouvelles énergies d’origine hydraulique, ainsi que le climat.

De manière générale, la croissance bleue impliquant l’ensemble des activités liées à la mer (énergies, ressources minérales, ports offshore, etc.) offre de très nombreuses perspectives de travaux au LHN. Un autre enjeu fort concerne la montée du niveau des mers d’ici 50 ou 100 ans. Dans cette perspective, les pouvoirs publics ont besoin d’outils afin de les aider à redéfinir la meilleure stratégie à mettre en œuvre afin de minimiser les impacts du changement climatique.